在数字化转型浪潮席卷全球的今天,数据已成为企业的核心资产与战略资源。许多企业面临一个共同的困境:数据采集、存储、计算等基础建设已初具规模,但业务部门仍然感觉数据“用不起来”,难以快速、灵活地将数据转化为业务洞察与决策支持。这关键的阻滞点,正是从“数据”到“业务价值”的“最后一公里”。而“数据服务化”与“数据处理服务”的理念与实践,正是打通这最后一公里的关键路径与核心引擎。

一、 何为数据服务化?

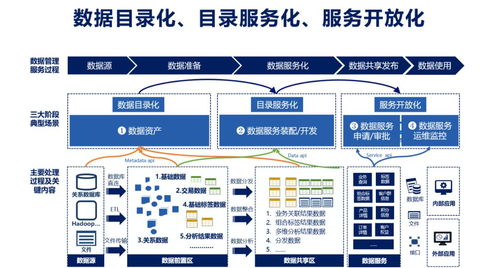

数据服务化,简而言之,是将企业内部复杂、原始、分散的数据,通过标准化的接口、规范化的流程和平台化的支撑,封装成易于理解、方便调用、安全可靠的“数据服务”,并以API(应用程序接口)为主要形式,提供给业务应用、分析人员乃至合作伙伴使用。其核心目标是将数据从后台的“资源”转变为前台可直接消费的“服务”,实现数据的“随需而用”。

这不仅仅是技术层面的接口化,更是一种组织文化与运营模式的转变。它要求打破传统烟囱式的数据孤岛,建立统一的数据资产目录、服务治理体系和运营监控机制,确保数据服务的一致性、可用性与安全性。

二、 “最后一公里”的挑战何在?

在数据服务化之前,企业数据应用的“最后一公里”往往充满荆棘:

- 获取难:业务人员或开发者需要深入理解底层数据结构、ETL流程,甚至直接写复杂SQL或代码从数据仓库中提取数据,门槛高、耗时长。

- 口径乱:同一业务指标,不同部门或报表可能因计算逻辑、统计时间点不同而产生差异,导致“数据打架”,信任缺失。

- 响应慢:一个新的数据分析需求,从提出到开发、测试、上线,往往需要数周甚至数月,无法适应业务的快速变化。

- 安全风险:数据直接开放库表权限,存在敏感信息泄露、资源被恶意占用等风险,管控困难。

三、 数据处理服务:服务化的核心支撑

数据服务化并非空中楼阁,其坚实底座是强大、敏捷、可管理的“数据处理服务”。这不仅仅是运行几个ETL任务,而是一套覆盖数据全生命周期的平台化能力:

- 敏捷开发与编排:提供可视化或低代码的数据处理任务开发环境,支持复杂工作流的灵活编排,快速响应新的数据加工需求。

- 任务调度与运维:具备高可靠、高可用的分布式调度能力,保障数据处理任务准时、稳定运行,并提供完善的监控、告警与故障恢复机制。

- 统一服务封装:将处理后的标准化数据模型(如指标、维度、标签),通过自动化的服务生成工具,封装成标准的API服务,并发布到统一的API网关。

- 资源与成本优化:对计算和存储资源进行智能管理与弹性伸缩,在保障性能的有效控制数据处理成本。

通过标准化的数据处理服务,企业能够将数据加工逻辑固化、资产化,并以服务形式输出,确保了数据产出的质量、效率与可复用性。

四、 如何有效实施,打通最后一公里?

打通数据应用的最后一公里,需要技术、组织与流程的协同推进:

- 顶层设计,统一治理:建立企业级的数据中台或数据服务平台,制定统一的数据标准、服务规范和安全策略。设立数据服务治理团队,负责服务的规划、审核、发布与运维。

- 资产盘点,服务构建:对核心数据资产进行盘点与建模,优先将高频、高价值的业务场景(如实时用户画像、精准营销推荐、经营分析报表等)所需的数据,通过数据处理服务加工成标准数据模型,并封装为服务。

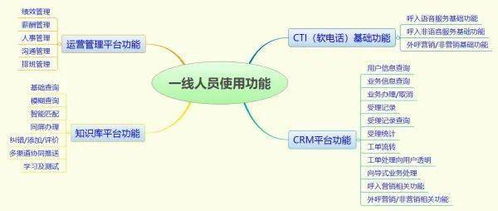

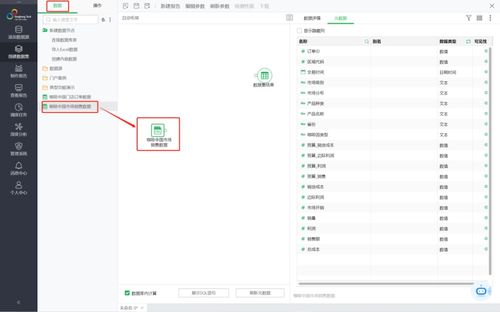

- 平台赋能,自助取数:建设面向业务用户(如数据分析师、产品运营)的自助数据分析平台或数据服务市场。用户可以通过搜索、浏览的方式,像网购一样发现、理解并直接调用已封装好的数据服务,或通过简单拖拽生成新的数据产品,极大降低用数门槛。

- 运营迭代,价值闭环:建立数据服务的运营机制,监控服务调用量、性能、满意度等指标。根据业务反馈持续迭代和优化数据服务,形成“业务提出需求 -> 快速开发服务 -> 业务消费验证 -> 反馈优化”的价值闭环。

###

数据服务化与数据处理服务,是让数据从“成本中心”走向“价值中心”的关键一跃。它通过将数据能力产品化、服务化,不仅解决了数据应用的“最后一公里”难题,更在深层次上推动了企业向数据驱动型组织的演进。当数据能够像水电一样,通过标准接口被安全、便捷、高效地取用时,数据的潜能才得以真正释放,成为驱动企业创新与增长的核心引擎。